离线时利用Redis加快数据更新(redis离线更新)

离线时利用Redis加快数据更新

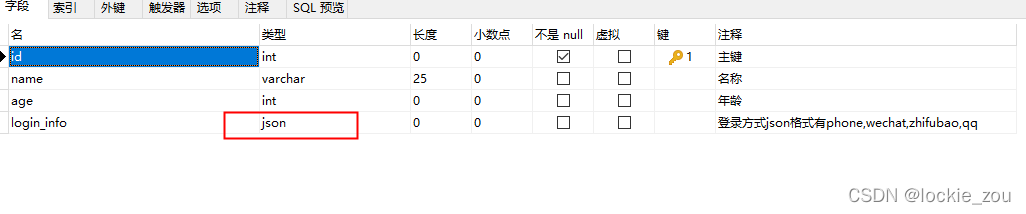

随着现代应用程序对数据处理速度的要求不断提高,使得传统的关系型数据库已经无法满足现代应用程序的需求。相反,键值存储数据库Redis成为了常见的解决方案。Redis以其快速、高效和可扩展的特点受到开发人员的喜欢。随着离线数据处理的日益普及,Redis的使用也越来越受到关注,离线时利用Redis加快数据更新在数据处理中发挥了重要作用。

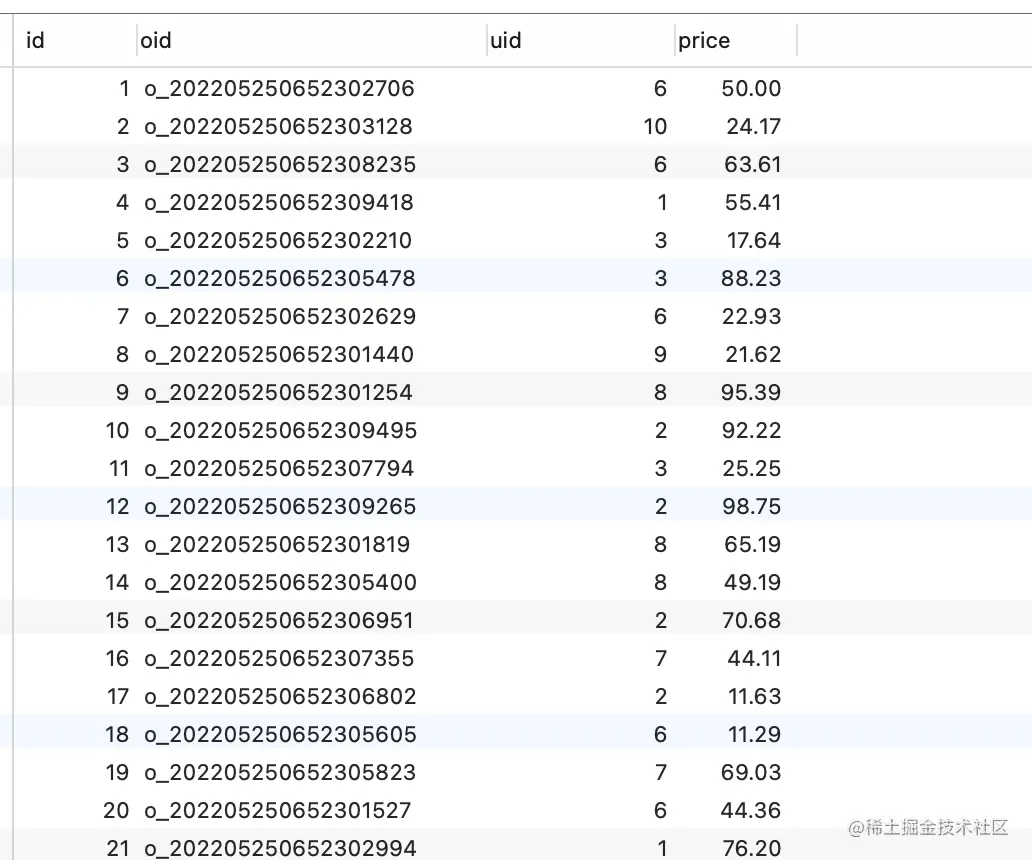

在传统应用程序中,当我们需要更新数据时,通常会直接从数据库中读取数据并更新,这样的方式在更新大量数据时效率较低。而离线数据处理则是一种让数据在后台离线处理,然后将处理结果存储到缓存中,从而加快数据更新的方式。Redis提供了很好的支持,并且通过使用Redis的持久性功能,可以保证这些数据处理结果在服务器故障时不会丢失。

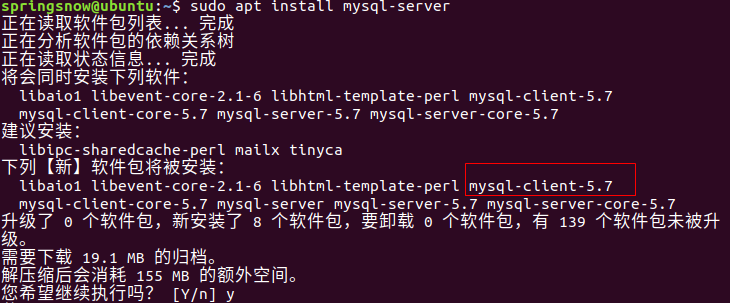

现在让我们看看如何在Python中使用Redis来实现离线数据处理。我们需要通过pip安装redis模块。

pip install redis

接下来,创建一个Python脚本来演示如何使用Redis进行离线数据处理。

import redis

import jsonfrom time import time

# 连接Redisr = redis.Redis(host='localhost', port=6379)

# 模拟重量批量更新操作def update_records():

data = [] for i in range(10000):

data.append({'id': i, 'name': 'user' + str(i), 'eml': 'user' + str(i) + '@example.com'})

return data

# 离线数据处理def offline_processing():

start_time = time()

# 批量更新数据 data = update_records()

key = 'users_data' r.set(key, json.dumps(data))

end_time = time()

# 输出运行时间 print('Elapsed time:', end_time - start_time)

# 更新操作def update_records_realtime(user_ids):

for user_id in user_ids: eml = 'user' + str(user_id) + '@example.com'

r.hset('users:' + str(user_id), 'eml', eml)

# 实时增量更新def realtime_updates():

# 实时更新前100个用户 update_records_realtime(range(100))

# 获取离线数据处理的结果 key = 'users_data'

data = r.get(key)

# 反序列化JSON数据 users = json.loads(data)

# 实时更新剩余用户 user_ids = [user['id'] for user in users if user['id'] >= 100]

update_records_realtime(user_ids)

# 测试效果if __name__ == '__mn__':

offline_processing() realtime_updates()

通过这段代码,我们创建了一个离线数据处理的例程,它使用Redis将结果存储到缓存中。在实际应用中,我们可以在用时更新数据,而且不需要重新生成所有的数据。这个例子中,我们只更新了前100个用户的数据,然后获取之前离线处理结果并更新剩余用户的数据。

总结

Redis是一个快速、高效、可扩展的键值存储数据库,它已经成为现代应用程序处理数据的首选方案。离线数据处理技术是在应用程序中加快数据更新的一种很好的方式。通过使用Redis在后台离线处理数据,并将处理结果存储在缓存中,我们可以有效地提高数据更新的速度。通过这篇文章,我们探讨了如何使用Python编写离线数据处理代码,通过示例演示了如何使用Redis进行数据缓存和实时增量更新。