慢上演ETL导入Oracle的痛苦实录(etl导入oracle慢)

慢上演!ETL导入Oracle的痛苦实录

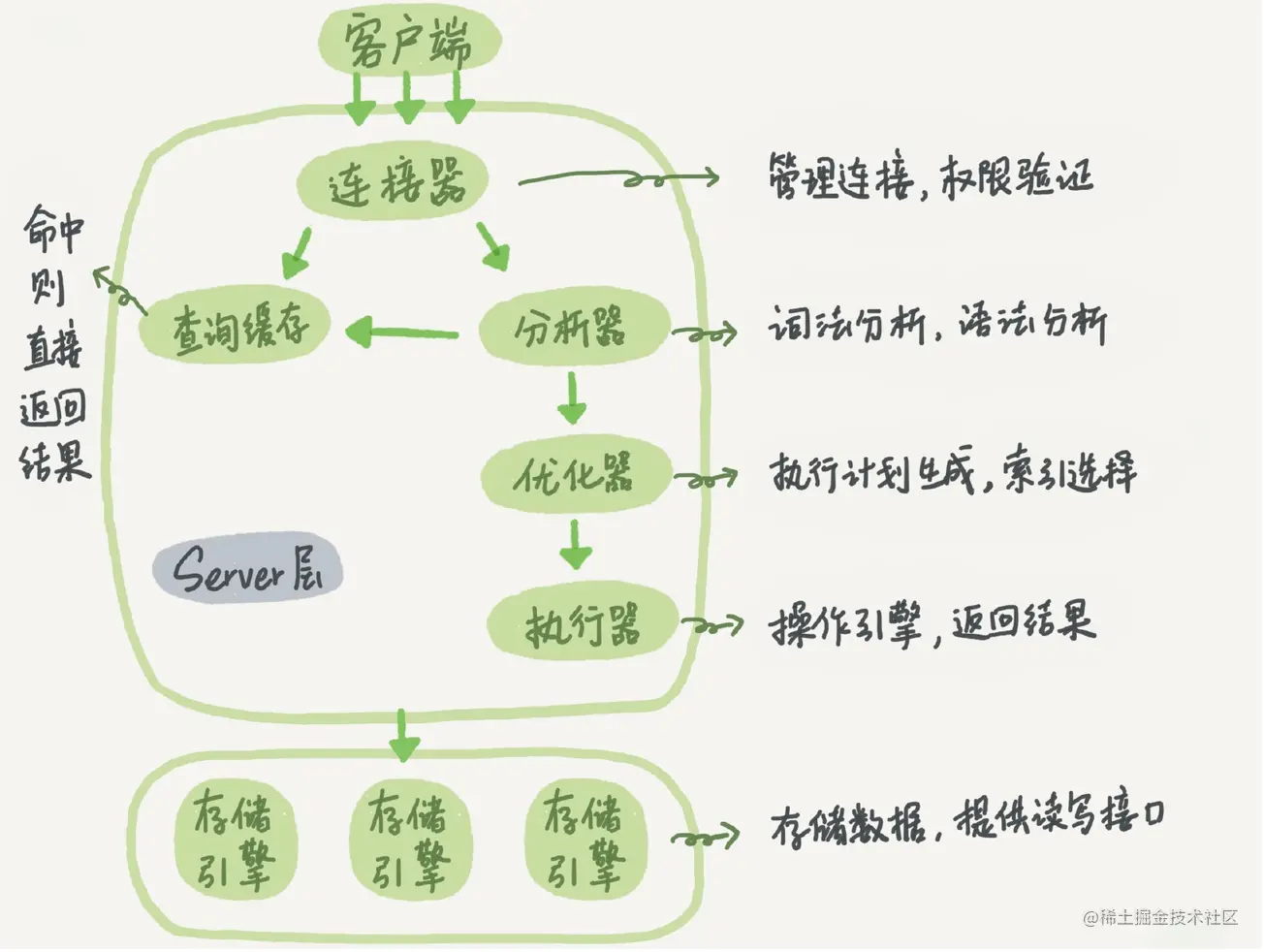

ETL(Extract, Transform, Load)是数据仓库建设中不可或缺的一个环节,其主要功能是从不同数据源中提取数据,并将其转化为符合数据仓库模型要求的格式,最后加载到数据仓库中,用于数据分析和业务决策。然而,尽管ETL在理论上的优势显著,但在实际应用中,ETL作业的性能问题却时有所闻,本文就是一篇关于ETL导入Oracle时的性能问题的实际操作分析,提醒大家注意实际执行时的细节。

让我们来了解一下ETL导入Oracle时的基本流程。在本次数据仓库建设中,我们使用了Kettle和DataStage两款ETL工具,以下将以Kettle为例,讲述具体流程。

1. 获取源数据

在Kettle的Trans中需要定义对源数据进行的操作,包括输入数据源连接的方式和如何获取源数据等。我们可以通过读取本地文件、连接文件服务器中的文件、连接关系数据库、连接各类数据仓库等方式获取源数据。

2. 数据转换

数据转换是ETL的核心环节,我们需要将源数据进行一定格式的转换,使其符合数据仓库的建模要求。Kettle提供了转换步骤包括数据清洗、数据过滤、数据整合、字段计算、条件分支等,这些步骤可以按照实际需要进行配置,使源数据得到一个最终的清晰、结构良好的数据集。

3. 目标数据连接

完成数据转换后,需要将处理好的数据导入到目标数据库中。在Kettle的Trans中设定操作目标数据集的方式,包括使用ODBC连接到源数据集、使用ODBC连接到数据仓库的方式等,支持多种输出目标。如果使用Oracle,我们需要配置数据库连接等相关信息。

4. 数据装载

数据装载是最后一个环节,需要将处理好的数据写入到Oracle数据库中。我们需要定义写入的方式,包括重新创建表、更新表、插入新纪录等,针对不同的场景进行不同配置。如果存在大批量的数据写入,我们需要考虑使用批量提交的方式,避免频繁地进行数据库连接和事务提交。

以上是Kettle导入Oracle的基本流程,我们将在这一基础上,针对实际操作中遇到的性能问题,进行具体的分析和解决。

1. 源数据准备不充分

当我们从多种来源获取源数据时,各个数据源的数据格式和质量是不同的。有些数据源中可能存在数据冗余和不规范的数据项,而这些数据项对于最终的数据质量会造成很大损害。我们应该提前分析源数据的规范性和一致性,对不规范的数据进行清理和格式化,保证数据的质量。

2. 数据转换步骤设计不合理

数据转换是一个比较复杂的工作,尤其是处理大量数据时,几乎每个步骤都需要有良好的设计才能保证ETL作业的性能。我们需要避免在转换过程中使用复杂的计算、查询或分组操作,避免使用大量数据聚合操作,避免使用子查询等容易攀升成本的操作。

3. 目标数据连接配置不合理

在连接目标数据库时,我们需要检查ODBC连接和网络带宽等参数,保证连接的畅通和稳定。如果使用Oracle,还需要合理地配置连接池和连接数等参数,尤其是在高并发和大数据量的场景下,保证连接稳定可以减少大量重连的开销。

4. 数据写入效率低下

在最后一个环节,我们需要做好性能优化的准备。作者曾经遇到过在处理大数据量时,由于没有使用批量提交操作,在重复提交事务操作的过程中总是导致超时和连接错误,从而影响了整个数据仓库作业的性能。因此,在写入数据到目标数据集时,我们需要避免重复连接和提交事务等操作,尽可能地减少数据库连接的变更。同时,可以使用批量提交的方式,每次提交一定量的数据,避免频繁地进行数据库连接和事务提交。

虽然ETL系统在理论上有很多的优势,但在实际应用中,性能优化是减少问题的关键。我们需要充分了解各个环节的执行流程,并在执行细节上作出优化措施,提高导入Oracle时的性能。